(杭州25日讯)第二场围棋人机大战已定胜负,人类再败给人工智能。究竟为什么AlphaGo的棋力那么惊人?DeepMind披露,AlphaGo采用谷歌云端平台TPU,运算时耗能仅为过去的1/10。

AlphaGo团队周三在主办单位举办的论坛上表示,和柯洁比赛的新版AlphaGo,比去年战胜韩国棋王李世石的版本更强。新版AlphaGo可在比赛中让旧版AlphaGo三子后还能获胜。

对此,柯洁在微博上回应指,虽然早就知道新版AlphaGo的实力强大,但仍对其竟可“让三子”而感到难以置信,高呼“我的天!”

他解释,“让三子”即是“一人一手轮流下的围棋,对手连续让你下3步”,简单而言“又像武林高手对决让你先捅3刀一样”,不禁叹道“我到底是在和一个怎样可怕的对手下棋。”

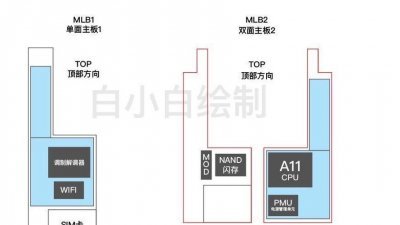

而2010年创立的DeepMind团顿周二披露,目前AlphaGo是在云端由单机版TPU(Tensor Processing Units,机器学习专用晶片)运行,使用与谷歌于上周谷歌开发者大会最新发表、专为机器学习制造的同款晶片;与去年3月和李世石的比赛时相比,现在的版本在运算时消耗的能量仅为过去的1/10。

AlphaGo围棋训练的第一步,是将人类棋谱输入电脑,学习人类的落子习惯。而AlphaGo会把输入系统的人类棋谱的每一步进行分拆,棋盘上每个落子以及随后的应对落子算作一个样本,AlphaGo从这些人类棋局中,分解出了3000多万个样本。

这些样本集合在一起,能够识别出每个特定的落子之后,哪一种应对方法的概率最高,这个最高的概率,其实就是人类棋手最喜欢的应对方法。

围棋毕变化太多,AlphaGo也需要更多的棋局来学习,于是通过自我对弈产生新的棋局,得出一套棋力比最初只学习人类下法厉害很多的新策略。

.jpg/a9e86fc62fc321bf5fa6b9940a5125d3.jpg)